Il meglio di Amazon, a portata di click

Il meglio di Amazon, a portata di click

MANUALI TECNICI

PROTOCOLLO SIP (SESSION INITIATION PROTOCOL)

Se la tradizionale centrale telefonica era composta da cavi e relè, il protocollo SIP (Session Initiation Protocol) rappresenta il “direttore d’orchestra” nell’universo del VoIP. Dal punto di vista tecnico, il SIP è un protocollo di segnalazione a livello applicativo, standardizzato dall’IETF nel documento RFC 3261. È fondamentale comprendere che il SIP non si occupa della trasmissione della voce, ma è responsabile esclusivamente della gestione, dell’avvio e della chiusura delle sessioni.

Ecco i dettagli tecnici del suo funzionamento:

L’Architettura: Chi parla con chi?

Il SIP si basa su un modello client-server, ma in modo distribuito. Gli attori principali sono:

- User Agent (UA): Lo smartphone, il telefono VoIP o il PC. Si divide in Client (chi chiama) e Server (chi riceve).

- Proxy Server: Un intermediario che riceve la richiesta e la inoltra verso la destinazione corretta.

- Registrar Server: Un database che “sa” dove ti trovi. Quando il tuo telefono si connette al Wi-Fi, invia un messaggio al Registrar dicendo: “Ehi, l’utente Mario è raggiungibile all’indirizzo IP 192.168.1.X”.

Il Messaggio SIP: Simile all’HTTP

Se hai mai visto il codice di una pagina web, il SIP ti sembrerà familiare. È un protocollo testuale (non binario). Un tipico invito a iniziare una chiamata appare così:

- INVITE sip:mario@esempio.it SIP/2.0

- Via: SIP/2.0/UDP 10.1.1.1:5060

- From: “Luigi” <sip:luigi@esempio.it>

- To: “Mario” <sip:mario@esempio.it>

Nota Tecnica: Il SIP usa solitamente la porta 5060 (UDP o TCP) per la segnalazione.

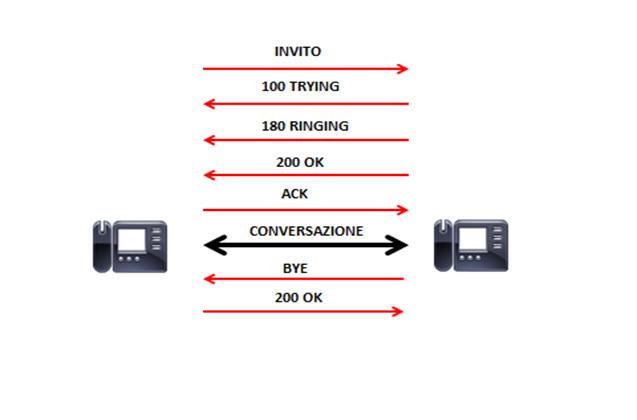

Il Flusso della Chiamata (Handshake)

Immaginate una telefonata tra Luigi e Mario. Ecco cosa succede “sotto il cofano”:

- INVITE: Luigi invia un pacchetto INVITE al server.

- 100 Trying / 180 Ringing: Il server risponde che sta cercando Mario e che il telefono di Mario sta squillando.

- 200 OK: Mario risponde alla chiamata.

- ACK: Luigi conferma di aver ricevuto la risposta. Solo a questo punto la sessione è stabilita.

La Separazione dei Piani: SIP vs RTP

Questo è il punto tecnico più critico. Una volta che il SIP ha “messo in contatto” i due utenti, esso si fa da parte.

- Piano di Controllo (SIP): Gestisce squilli, attese e chiusura (il “citofono”).

- Piano Media (RTP): La voce vera e propria viaggia su un protocollo diverso chiamato RTP (Real-time Transport Protocol). I pacchetti voce non passano necessariamente dal server SIP, ma fluiscono direttamente tra i due interlocutori per ridurre la latenza.

La Negoziazione: Il protocollo SDP

Come decidono i due telefoni quale codec usare (alta qualità o risparmio dati)? All’interno del pacchetto SIP è contenuto l’SDP (Session Description Protocol). È una sorta di “contratto” in cui i due dispositivi si dicono: “Io parlo italiano e inglese, tu?” – “Io parlo solo inglese” – “Ok, allora usiamo l’inglese”. Tecnicamente, negoziano i Codec (come G.711 o G.729).

Perché il SIP è così rivoluzionario?

- Indipendenza dall’hardware: Può girare su qualsiasi dispositivo IP.

- Mobilità: Puoi spostare il tuo telefono in un altro ufficio e, finché c’è internet, manterrai lo stesso numero.

- Multimedialità: Gestisce video, chat e condivisione file con la stessa logica della voce.

CONFIGURARE UN ACCOUNT SIP

Configurare un account SIP su un software (comunemente chiamato Softphone, come Zoiper, Linphone o MicroSIP) è un processo che traduce i concetti teorici che abbiamo visto in parametri pratici.

Ecco i passaggi tecnici e i dati necessari per rendere operativo un interno telefonico o un numero VoIP.

I Dati Necessari (Le Credenziali)

Per configurare il client, il tuo provider VoIP o il tuo centralino aziendale (PBX) deve fornirti quattro parametri fondamentali:

- SIP User ID / Username: Spesso coincide con il numero di telefono o l’interno (es. 201).

- Password: Una stringa alfanumerica sicura.

- Domain / Registrar: L’indirizzo IP o il nome DNS del server SIP (es. voip.provider.it o 192.168.1.50).

- Auth Name (Opzionale): Un nome identificativo per l’autenticazione, spesso uguale allo Username.

ESEMPIO DI CONFIGURAZIONE SU MICROSIP

MicroSIP ( è una semplice applicazione che ti permette di effettuare chiamate attraverso qualsiasi account SIP) è uno dei client più leggeri e utilizzati in ambito tecnico per testare le linee. Ecco come appare la schermata di configurazione:

- Account Name: Un nome a tua scelta (es. “Ufficio”).

- SIP Server: sip.tuoprovider.it

- SIP User: 021234567 (il tuo numero).

- Domain: sip.tuoprovider.it

- Login: user_autenticazione

- Password: ********

- Transport: Solitamente impostato su UDP (più veloce per la voce), ma può essere TCP o TLS (per chiamate criptate).

Parametri Avanzati: Codec e Network

Una volta inseriti i dati base, si passa alla raffinazione tecnica nelle impostazioni avanzate:

Selezione dei Codec

Qui si decide come la voce viene compressa. In un ambiente software puoi solitamente trascinare i codec in ordine di priorità:

- G.711 (alaw/ulaw): Alta qualità, nessuna compressione, occupa circa 80-90 kbps. È lo standard della telefonia fissa.

- G.729: Alta compressione, occupa solo 8 kbps. Ideale se la connessione internet è instabile o limitata.

- Opus: Il re dei codec moderni, adattivo e con qualità cristallina.

Il problema del NAT (Keep-alive)

Poiché il protocollo SIP viaggia su internet, spesso il tuo PC è collegato a un router (NAT). Se il router “chiude la porta” dopo un po’, smetterai di ricevere chiamate.

- STUN Server: Si usa un server esterno per aiutare il software a capire il proprio indirizzo IP pubblico.

- Keep-alive: Il software invia piccoli pacchetti “vuoti” ogni 20-30 secondi per dire al router: “Ehi, tieni aperta questa porta, sono ancora qui!”.

Verifica della Registrazione

Dopo aver cliccato “Salva”, il software avvia il processo di REGISTER che abbiamo descritto prima.

- Se vedi “Online” o un’icona verde: Il server ha accettato le tue credenziali (200 OK).

- Se vedi “403 Forbidden”: La password o lo username sono errati.

- Se vedi “Request Timeout”: Il software non riesce a raggiungere il server (problema di rete o firewall).

PROTOCOLLO DI SICUREZZA

Garantire la sicurezza in una rete VoIP è cruciale perché, a differenza della vecchia linea analogica (dove bisognava “attaccarsi” fisicamente ai cavi), i pacchetti IP viaggiano su reti pubbliche e possono essere intercettati da chiunque abbia accesso ai nodi di rete tramite tecniche di sniffing.

Per proteggere una conversazione, la sicurezza agisce su due fronti separati: la segnalazione (chi chiama chi) e il flusso audio (cosa ci si dice).

Proteggere la Segnalazione: SIPS (TLS)

Il primo passo è impedire che un malintenzionato possa vedere i metadati della chiamata (numeri chiamati, identità degli utenti).

- Tecnica: Si utilizza il TLS (Transport Layer Security), lo stesso protocollo che protegge la navigazione web (HTTPS).

- Funzionamento: Invece del normale protocollo SIP sulla porta 5060, si usa il SIPS (Secure SIP) solitamente sulla porta 5061.

- Risultato: Tutti i messaggi di controllo (INVITE, BYE, etc.) vengono criptati tramite certificati digitali. Nessun estraneo può vedere chi stai chiamando.

Proteggere l’Audio: SRTP

Criptare il SIP non basta: se l’audio viaggia in chiaro (RTP standard), un hacker potrebbe comunque ricostruire il file audio dai pacchetti catturati.

- Tecnica: Si utilizza il SRTP (Secure Real-time Transport Protocol).

- Cifratura: L’algoritmo standard utilizzato è l’AES (Advanced Encryption Standard), solitamente a 128 o 256 bit.

- Risultato: Anche se qualcuno intercettasse i pacchetti voce, sentirebbe solo rumore bianco indecifrabile.

Lo scambio delle chiavi: ZRTP e SDES

Il problema tecnico più complesso è: come fanno i due telefoni a scambiarsi la chiave di cifratura senza che qualcuno la intercetti durante il passaggio?

Esistono due metodi principali:

- SDES (SRTP Destination Security): La chiave viene scambiata all’interno del messaggio SIP (protetto da TLS). È il metodo più usato dai provider aziendali.

- ZRTP: Inventato da Phil Zimmermann (il creatore di PGP). Non si fida della rete. I due telefoni scambiano le chiavi direttamente sul canale audio usando un protocollo chiamato Diffie-Hellman.

- Verifica: Per evitare attacchi “Man-in-the-Middle”, sullo schermo dei due telefoni appare un codice di due parole (es. “Gatto – Luna”). Se entrambi gli utenti leggono le stesse parole a voce, la connessione è sicura al 100%.

Difesa della Centrale: SBC (Session Border Controller)

Oltre alla cifratura dei dati, le centrali moderne usano un componente hardware/software chiamato SBC. È il “Bodyguard” della rete VoIP e si occupa di:

- DDoS Protection: Impedisce che un attacco informatico mandi in crash il centralino inondandolo di richieste.

- Topology Hiding: Nasconde la struttura interna della rete aziendale all’esterno.

- Firewall SIP: Ispeziona ogni pacchetto per assicurarsi che sia un comando telefonico legittimo e non un tentativo di hacking.

Sintesi della protezione “End-to-End”

Per avere una sicurezza totale, una chiamata moderna segue questo schema:

- Autenticazione: Lo User Agent deve autenticarsi con username e password criptate (Digest MD5/SHA).

- Canale SIPS (TLS): Protegge i messaggi di setup.

- Canale SRTP (AES): Protegge il flusso della voce.

- VPN (Opzionale): Per una protezione ulteriore, il telefono può creare un tunnel criptato verso l’azienda prima ancora di iniziare la sessione SIP.

COME GESTIRE MILIONI DI CHIAMATE SIMULTANEE SENZA RITARDI (LATENZA)

Gestire milioni di chiamate simultanee senza che la voce sembri arrivare “da Marte” (latenza) o che si senta a scatti (jitter) è una sfida ingegneristica monumentale. Per i grandi operatori (Tier 1 come TIM, AT&T o Vodafone), la soluzione non è solo “aumentare la banda”, ma applicare architetture di rete ultra-specializzate.

Ecco i pilastri tecnici su cui si regge questa infrastruttura:

Architettura IMS (IP Multimedia Subsystem)

Le reti moderne non sono più una massa informe di server, ma seguono lo standard IMS. È un’architettura a strati che separa nettamente le funzioni:

- Service Layer: Dove risiedono i servizi (segreteria, deviazioni).

- Control Layer: Gestisce la segnalazione (SIP) tramite i CSCF (Call Session Control Functions). Questi server gestiscono milioni di registrazioni simultanee distribuendo il carico.

- Transport Layer: Il “tubo” dove viaggia l’audio. Questa separazione permette di scalare: se aumentano le chiamate, l’operatore aggiunge server di controllo senza dover toccare quelli dei servizi.

QoS (Quality of Service) e Prioritizzazione

In una rete IP, i dati sono tutti uguali (pacchetti). Ma se un’email arriva con 1 secondo di ritardo non succede nulla; se succede alla voce, la chiamata è rovinata.

- Tagging dei pacchetti (DSCP): I pacchetti voce vengono “etichettati” nei campi dell’intestazione IP (solitamente con il valore EF – Expedited Forwarding).

- Code di priorità nei Router: Quando un router dell’operatore è congestionato, guarda le etichette. I pacchetti marchiati come “Voce” saltano la fila e passano per primi, mentre i dati web o i download vengono rallentati.

MPLS (Multi-Protocol Label Switching)

Per evitare i ritardi del normale instradamento internet (dove ogni router decide la strada migliore momento per momento), gli operatori usano reti MPLS.

- Percorsi Deterministici: L’MPLS crea dei “tunnel” predefiniti tra le centrali. Il pacchetto non deve essere analizzato da ogni router; segue un percorso fisso e ottimizzato (Label Switched Path), riducendo drasticamente i tempi di elaborazione.

Riduzione della Latenza e del Jitter

Per mantenere la latenza sotto i 150ms (soglia oltre la quale l’orecchio umano percepisce il ritardo), si usano due trucchi tecnici:

- Geo-ridondanza e Edge Computing: I server di gestione non sono in un unico punto, ma distribuiti sul territorio. La tua chiamata viene gestita dal server fisicamente più vicino a te.

- Jitter Buffer: All’estremità ricevente, un piccolo “polmone” di memoria riordina i pacchetti che potrebbero essere arrivati in ordine sparso a causa della rete, consegnandoli all’utente in modo fluido.

Hardware Dedicato: Media Gateway e SBC ad alta densità

A differenza di un piccolo ufficio che usa un software su un PC, i grandi operatori usano:

- SBC (Session Border Controller) Carrier-Grade: Hardware capace di gestire 100.000+ sessioni contemporanee con cifratura hardware (senza pesare sulla CPU).

- Trunking in Fibra Ottica: Collegamenti diretti tra operatori (Peering) tramite dorsali a 100Gbps o superiori, evitando di passare per l’Internet pubblica.

Hardware Dedicato: Media Gateway e SBC ad alta densità

A differenza di un piccolo ufficio che usa un software su un PC, i grandi operatori usano:

- SBC (Session Border Controller) Carrier-Grade: Hardware capace di gestire 100.000+ sessioni contemporanee con cifratura hardware (senza pesare sulla CPU).

- Trunking in Fibra Ottica: Collegamenti diretti tra operatori (Peering) tramite dorsali a 100Gbps o superiori, evitando di passare per l’Internet pubblica.

Sintesi delle performance

| Parametro | Obiettivo Carrier-Grade | Effetto se non rispettato |

| Latenza (Round Trip) | < 150 ms | Eco e sovrapposizione delle voci |

| Jitter (Variazione ritardo) | < 30 ms | Voce metallica o “a scatti” |

| Packet Loss | < 1% | Perdita di sillabe o caduta linea |

Questa enorme infrastruttura permette anche di gestire il passaggio tra rete fissa e mobile. Come avviene l’Handover, ovvero come la chiamata resta attiva mentre vi spostate in auto passando da una cella telefonica all’altra.

L’Handover (o Handoff) è una delle procedure più critiche e affascinanti delle reti mobili. Tecnicamente, si tratta del processo mediante il quale una sessione attiva (chiamata o connessione dati) viene trasferita da un canale radio a un altro senza interruzioni percepibili dall’utente.

Nelle reti moderne, questo avviene in frazioni di secondo (meno di 100ms), così velocemente che il cervello umano non avverte il “buco” audio.

Chi decide il passaggio? (Il monitoraggio)

Il tuo smartphone non è un ricevitore passivo; è un sensore attivo. Mentre sei in auto:

- Misurazione: Lo smartphone misura costantemente la potenza del segnale (RSRP) e la qualità (RSRQ) della cella a cui è collegato (Serving Cell) e di tutte le celle vicine (Neighbor Cells).

- Reporting: Invia periodicamente questi dati (chiamati Measurement Reports) alla stazione radio base (eNodeB in 4G o gNodeB in 5G).

- Soglia di Trigger: Quando il segnale della cella attuale scende sotto una certa soglia e quello di una cella vicina è più forte di un valore X (chiamato Hysteresis), il sistema decide di avviare l’handover.

Le fasi tecniche dell’Handover

Il processo segue tre fasi rigorose:

- Preparazione

La stazione radio attuale (Sorgente) contatta la stazione radio verso cui ti stai muovendo (Destinazione) tramite un’interfaccia ultra-veloce chiamata X2 (o Xn in 5G). Gli chiede: “Ho un utente che sta arrivando, hai risorse libere per lui?”. La cella di destinazione risponde con un Handover Request Acknowledge, prenotando le frequenze.

- Esecuzione (Il “Salto”)

La cella sorgente invia allo smartphone il comando: “Cambia ora!”.

- In questo istante, lo smartphone si scollega dalla vecchia cella e si sintonizza sulla nuova.

- Data Forwarding: Mentre lo smartphone sta “saltando”, la vecchia cella non butta via i pacchetti voce che arrivano dalla rete, ma li inoltra alla nuova cella tramite il tunnel X2, così che non vadano persi.

- Completamento

Una volta che lo smartphone si è agganciato alla nuova cella, questa invia un messaggio al “cuore” della rete (MME o AMF) dicendo: “L’utente è con me, d’ora in poi invia i pacchetti qui”. Il vecchio collegamento viene rilasciato.

Tipi di Handover: Hard vs Soft

Esistono due filosofie tecniche principali:

- Hard Handover (“Break-before-make”): Tipico del GSM e dell’LTE. Lo smartphone si scollega dalla vecchia cella un istante prima di collegarsi alla nuova. È estremamente efficiente in termini di frequenze ma richiede una sincronizzazione perfetta.

- Soft Handover (“Make-before-break”): Tipico del 3G (UMTS). Lo smartphone è collegato a più celle contemporaneamente durante la transizione. I segnali vengono combinati per garantire continuità totale, ma consuma molte più risorse di rete.

Handover tra tecnologie diverse (SRVCC)

- Cosa succede se sei in chiamata 4G (VoLTE) e finisci in una zona coperta solo dal vecchio 3G o 2G? Qui interviene il SRVCC (Single Radio Voice Call Continuity). È una procedura complessa che trasforma una chiamata a “pacchetti IP” (4G) in una chiamata a “commutazione di circuito” (2G/3G) in tempo reale. È l’equivalente tecnico di cambiare il motore a un’auto mentre corre a 100 km/h.

Il parametro critico: L’Isteresi

- Per evitare l’effetto “ping-pong” (lo smartphone che continua a saltare tra due celle quando sei esattamente a metà strada), gli ingegneri usano l’Isteresi. In pratica, la nuova cella deve essere non solo migliore della vecchia, ma significativamente migliore (ad esempio di almeno 3-5 dB) per un certo periodo di tempo (Time to Trigger) prima che il salto venga autorizzato.

Gestire una connessione stabile su un treno che sfreccia a 500 km/h è una delle sfide ingegneristiche più estreme della telefonia moderna. A quella velocità, attraversi la portata di una cella (lunga circa 500-1000 metri) ogni pochi secondi. In pratica, il tuo telefono è in uno stato di handover perenne.

Il 5G introduce quattro innovazioni tecniche fondamentali per risolvere questo problema:

Compensazione dell’Effetto Doppler

A 500 km/h, le onde radio subiscono una distorsione fisica: la frequenza si comprime mentre ti avvicini alla cella e si espande mentre ti allontani (come il suono di una sirena che cambia tonalità).

- Il problema: A frequenze 5G (come i 3.5 GHz o le onde millimetriche), lo spostamento Doppler è così forte da mandare “fuori sincronia” i simboli digitali.

- Soluzione 5G: Le stazioni radio base utilizzano algoritmi di pre-compensazione. Grazie alla conoscenza della traiettoria fissa del treno e alla stima della velocità in tempo reale (tramite sensori o segnali di riferimento), la cella “stona” preventivamente il segnale nel modo opposto, così che arrivi al treno perfettamente accordato.

Beamforming Dinamico e Beam Tracking

A differenza delle vecchie antenne che irradiavano segnale ovunque, il 5G usa il Massive MIMO per creare fasci di segnale stretti e precisi (Beams).

- Tecnica: Invece di aspettare che il segnale arrivi al treno, l’antenna “insegue” il vagone con un raggio dedicato.

- Beam Handover: Prima ancora che avvenga il salto tra due celle, il 5G gestisce l’handover tra i singoli fasci (beam-level mobility). Questo permette di mantenere un guadagno di segnale altissimo anche ai bordi della cella, dove solitamente la connessione cadeva.

Architettura a “Due Teste” (Dual Antenna & D-MIMO)

I treni ad alta velocità moderni non si affidano solo al tuo smartphone, ma usano antenne esterne sul tetto (Mobile Relay).

- Front/Rear Handover: Il treno ha un’antenna in testa e una in coda. Quando l’antenna in testa inizia la procedura di handover con la cella successiva, quella in coda è ancora stabilmente collegata alla cella precedente. Il sistema “shifta” i dati tra le due antenne in modo che, dal punto di vista dell’utente all’interno, non ci sia mai un millisecondo di buio.

- Distributed MIMO (D-MIMO): Diverse stazioni radio lungo i binari cooperano per servire il treno contemporaneamente, creando una “bolla” di copertura che si sposta con esso, eliminando di fatto il concetto di confine netto tra celle.

Predizione tramite AI e LSTM (Long Short-Term Memory)

Poiché un treno si muove su un percorso obbligato (i binari), il suo comportamento è altamente prevedibile.

- Handover Proattivo: Gli operatori usano modelli di Intelligenza Artificiale che sanno esattamente a che secondo il treno raggiungerà il punto critico.

- Trigger anticipato: Invece di aspettare che il segnale si indebolisca (metodo reattivo), il sistema avvia la preparazione dell’handover 800-900ms prima del necessario. Questo azzera i tempi di attesa e riduce il rischio di Radio Link Failure.

- Sintesi del miglioramento

| Problema | Soluzione 4G | Evoluzione 5G |

| Effetto Doppler | Correzione base | Pre-compensazione AI a 30GHz |

| Frequenza Handover | Ogni 20-30 sec | Ottimizzata per cicli di < 10 sec |

| Punti ciechi | Caduta della linea | Beam Tracking continuo |

| Stabilità | Reattiva (basata su potenza) | Proattiva (basata su posizione e AI) |

L’FRMCS (Future Railway Mobile Communication System) non è solo un aggiornamento tecnologico; è un cambio di paradigma totale. Se il vecchio GSM-R (basato sulla tecnologia 2G degli anni ’90) era paragonabile a un walkie-talkie potenziato, l’FRMCS è una dorsale digitale a banda larga che abilita la ferrovia autonoma e intelligente.

Ecco come le tecnologie 5G si integrano in questo standard per garantire la sicurezza ferroviaria europea:

La Transizione: Dal Circuito ai Pacchetti

Il GSM-R utilizzava la commutazione di circuito (canali dedicati). Questo era sicuro ma estremamente inefficiente: una volta occupato un canale per la voce, non c’era spazio per i dati.

- Integrazione FRMCS: Utilizza il “core” del 5G (architettura SBA – Service Based Architecture). Tutto è basato su pacchetti IP.

- Vantaggio: Permette la coesistenza di servizi critici (frenata di emergenza) e servizi video (telecamere di sicurezza sul treno) sulla stessa infrastruttura, garantendo però che i primi abbiano sempre la precedenza assoluta.

Network Slicing: Una “Corsia Preferenziale” Virtuale

Questa è la caratteristica più potente che l’FRMCS eredita dal 5G.

- Tecnica: L’operatore ferroviario crea diverse “fette” (slices) virtuali sulla stessa rete fisica.

- Slice 1 (Mission Critical): Riservata al segnalamento ferroviario (ETCS) e alla voce terra-treno. Ha latenza ultra-bassa e affidabilità del 99.999%.

- Slice 2 (Performance): Per la telemetria del treno e la manutenzione predittiva.

- Slice 3 (Business/Passenger): Per il Wi-Fi di bordo.

- Sicurezza: Anche se migliaia di passeggeri iniziano a guardare film in streaming contemporaneamente, la “fetta” del segnalamento non viene mai influenzata.

Supporto all’ETCS Level 3 (Automatic Train Control)

L’FRMCS è il braccio operativo del sistema di segnalamento ERTMS/ETCS.

- Moving Block: Grazie alla precisione e alla bassa latenza del 5G, i treni non devono più rispettare distanze fisse basate su “sezioni” di binario, ma possono viaggiare a pochi metri l’uno dall’altro mantenendo una “bolla di sicurezza” dinamica.

- Latenza: L’FRMCS garantisce tempi di risposta inferiori ai 10ms, essenziali per i sistemi di frenata automatica che devono reagire istantaneamente in caso di ostacoli rilevati dai sensori.

Comunicazione V2X (Vehicle-to-Everything)

L’FRMCS integra il concetto di C-V2X (Cellular Vehicle-to-Everything) adattato alle rotaie:

- V2V (Train-to-Train): I treni comunicano direttamente tra loro senza passare necessariamente dalla stazione radio centrale. Se un treno rileva un problema, avvisa istantaneamente quello che lo segue.

- V2I (Train-to-Infrastructure): Il treno dialoga con scambi, passaggi a livello e sensori meteo lungo la linea.

Resilienza e Frequenze Dedicate

A differenza del Wi-Fi pubblico o del 5G commerciale, l’FRMCS opera su bande di frequenza protette (solitamente intorno agli 885-915 MHz e 1900-1920 MHz) per evitare interferenze.

- Mission Critical Services (MCX): Integra standard come MCPTT (Mission Critical Push-To-Talk) e MCVideo, che permettono chiamate di gruppo istantanee tra macchinisti, capitreno e sale controllo con priorità di pre-rilascio (possono “buttare giù” altre chiamate meno importanti in caso di emergenza).

- Confronto Tecnico: GSM-R vs FRMCS

| Caratteristica | GSM-R (Oggi) | FRMCS (Futuro 5G) |

| Tecnologia Base | 2G (Digitale analogico) | 5G (Cloud Native) |

| Velocità Dati | 9.6 kbps (bassissima) | > 100 Mbps (alta) |

| Latenza | ~400-500 ms | < 10 ms |

| Capacità | Solo voce e piccoli messaggi | Video HD, Sensori, Guida Autonoma |

| Gestione Spettro | Inefficiente (Canali fissi) | Efficiente (Slicing e Dynamic Sharing) |

IL FUTURO DELL’INFRASTRUTTURA

L’Europa ha pianificato la dismissione definitiva del GSM-R entro il 2030-2035, il che significa che migliaia di chilometri di binari stanno venendo equipaggiati proprio ora con antenne 5G dedicate.

SATELLITI STARLINK

Se la gestione dell’handover per un treno a 500 km/h ti è sembrata complessa, quella dei satelliti Starlink porta la sfida a un livello letteralmente spaziale.

Un satellite Starlink orbita a circa 550 km di quota, viaggiando a una velocità di circa 27.000 km/h (7,5 km/s). Dalla prospettiva di un utente a terra (il terminale “Dishy”), un singolo satellite attraversa il cielo in soli 15 minuti, ma rimane utilizzabile per la connessione solo per circa 15-20 secondi prima che l’angolo di segnale diventi sfavorevole e sia necessario passare al satellite successivo.

Ecco come avviene tecnicamente questo “balletto” orbitale:

Handover Programmato (Time-Based)

A differenza dei telefoni cellulari, dove l’handover è reattivo (basato sulla potenza del segnale), in Starlink è deterministico e predittivo.

- L’Almanacco: Il tuo terminale a terra possiede un “almanacco” costantemente aggiornato con le orbite precise di tutti i satelliti della costellazione.

- Sincronizzazione Temporale: Poiché le traiettorie sono matematicamente note, l’handover non avviene perché il segnale “svanisce”, ma perché scatta un timer preciso al millisecondo. Il terminale sa esattamente quando il satellite A uscirà dal suo cono di visibilità e quando il satellite B sarà in posizione ottimale.

Antenne Phased Array (Il passaggio senza parti mobili)

Il segreto tecnologico è l’antenna Phased Array (a scansione di fase) presente sia sul satellite che sul terminale.

- Puntamento Elettronico: Invece di ruotare fisicamente una parabola, l’antenna usa migliaia di piccoli elementi radianti. Variando i ritardi infinitesimali tra questi elementi, l’antenna crea un fascio costruttivo che può essere “piegato” elettronicamente.

- Il Salto: Durante l’handover, l’antenna a terra può creare due fasci contemporaneamente per una frazione di secondo (uno verso il satellite vecchio e uno verso il nuovo), effettuando un Soft Handover che garantisce zero perdita di pacchetti.

Laser Inter-Satellite Links (ISL)

Questa è la vera rivoluzione dei modelli Starlink più recenti (V1.5 e V2).

- Il problema: Nei primi modelli, il satellite doveva “vedere” contemporaneamente l’utente e una stazione di terra (Gateway). Se eri in mezzo all’oceano, non c’era connessione.

- La soluzione: I satelliti comunicano tra loro nello spazio tramite laser. Quando avviene l’handover a terra, il traffico dati viene reinstradato nella “mesh” spaziale. Se il satellite A ti sta lasciando, i tuoi dati vengono già inviati via laser al satellite B, che li proietterà verso di te non appena sarai nel suo cono.

Gestione della Latenza e del Doppler “Spaziale”

Con velocità di 7,5 km/s, lo spostamento Doppler è massiccio.

- Tracking Continuo: Il sistema corregge la frequenza dei pacchetti migliaia di volte al secondo per compensare lo spostamento verso il blu (mentre il satellite si avvicina) e verso il rosso (mentre si allontana).

- Cambio di Cella Spaziale: Starlink divide la Terra in “celle” esagonali virtuali. Il sistema di controllo a terra (il Network Operations Center) assegna dinamicamente i satelliti alle celle. Un satellite può gestire centinaia di celle diverse durante il suo passaggio, regolando la potenza dei suoi fasci in base alla densità di utenti.

La Sfida del “Make-before-Break”

Per evitare interruzioni durante le videochiamate o il gaming online, Starlink utilizza una tecnica di buffering e commutazione ultra-rapida:

- Prep: Il terminale riceve l’ordine di prepararsi al passaggio.

- Sync: Viene stabilito un secondo link logico con il satellite subentrante.

- Switch: Il flusso di pacchetti IP viene spostato sul nuovo link.

Tutto questo avviene in circa 10-40 millisecondi, un tempo così breve che i protocolli di rete (come il TCP) non si accorgono nemmeno del cambio di “ponte” radio.

Sintesi Tecnica: 5G vs Starlink Handover

| Caratteristica | 5G (Alta Velocità) | Starlink |

| Velocità Relativa | 500 km/h | 27.000 km/h |

| Puntamento | Settoriale / Beamforming | Phased Array (Elettronico) |

| Logica | Reattiva (Segnale basso) | Predittiva (Almanacco orbitale) |

| Backhaul | Fibra ottica alla base | Laser spaziali (Mesh) |

Gestire migliaia di utenti simultanei in una zona densa (come una città) è la vera sfida di Starlink. A differenza della fibra ottica, la larghezza di banda di un satellite è una risorsa finita e condivisa: se tutti “urlano” contemporaneamente, nessuno viene ascoltato.

Per risolvere questo problema di congestione, SpaceX utilizza un mix di tecnologie di suddivisione dello spazio e del tempo. Ecco come funziona tecnicamente:

La divisione del territorio: Celle Esagonali

Starlink non vede la città come una massa informe, ma la divide in una griglia di celle esagonali (larghe circa 15-20 km).

- Allocazione dinamica: Ogni satellite dispone di diverse antenne phased array in grado di generare numerosi fasci (spot beams).

- Gestione della densità: In una città come Milano o Roma, il satellite non invia un unico grande fascio, ma concentra più fasci stretti sulle celle più popolate, riutilizzando le stesse frequenze in celle distanti per evitare interferenze (tecnica del Frequency Reuse).

Multiplexing: Dividere il “tempo” e la “frequenza”

Quando migliaia di terminali (Dishy) in una città sono collegati allo stesso satellite, non trasmettono tutti insieme a caso. Il satellite coordina l’accesso tramite due tecniche principali:

- OFDMA (Orthogonal Frequency Division Multiple Access): La banda totale disponibile viene divisa in migliaia di piccoli sottocanali di frequenza. Diversi utenti possono trasmettere contemporaneamente, ognuno su un “binario” diverso.

- TDMA (Time Division Multiple Access): Il tempo viene diviso in slot millesimali. Il satellite dice al terminale A: “Tu trasmetti nei millisecondi 1, 3 e 5”, e al terminale B: “Tu nei millisecondi 2, 4 e 6”.

Spatial Multiplexing e Massive MIMO

Grazie alle antenne phased array, Starlink può fare quello che viene chiamato SDMA (Space Division Multiple Access).

- Fasci multipli: Un singolo satellite può generare fasci indipendenti che puntano a zone diverse della città contemporaneamente.

- Isolamento del segnale: Questi fasci sono così precisi che il segnale destinato all’utente nel quartiere A non “inquina” il segnale dell’utente nel quartiere B, permettendo al satellite di servire entrambi con la massima velocità.

Traffic Shaping e Quality of Service (QoS)

Quando la domanda supera la capacità fisica del satellite (congestione), entra in gioco lo strato software di gestione del traffico:

- Prioritizzazione: I pacchetti non sono tutti uguali. Le query DNS e i pacchetti voce (VoIP) hanno la priorità assoluta per mantenere la navigazione fluida.

- Fair Share Policy: Starlink utilizza algoritmi di “equità”. Se un utente sta scaricando un file enorme saturando il canale, il sistema riduce temporaneamente la sua velocità per garantire che gli altri utenti possano almeno navigare o guardare video in streaming.

- Incentivi al roaming: I terminali “Mobile” (quelli sui camper o barche) hanno solitamente una priorità inferiore rispetto ai terminali “Residenziali” fissi nelle zone congestionate.

Il “Bypass” tramite Ground Stations (Gateway)

Il satellite è solo un ponte. Se migliaia di persone scaricano dati, il satellite deve “scaricare” a sua volta questo traffico verso terra.

- Capacità di Backhaul: Il satellite si collega a più Gateway (stazioni di terra collegate alla fibra ottica) contemporaneamente. Se un Gateway in zona è saturo, il satellite può inviare i dati a un Gateway più lontano o trasmetterli via laser a un altro satellite che vola sopra una zona meno affollata, scaricando il traffico lì.

In sintesi: Perché la città è “difficile”?

Nonostante queste tecnologie, Starlink rimane un sistema “limitato” rispetto alla fibra. Per questo motivo:

- In zone densissime, SpaceX può applicare il “Waitlist” (bloccare nuovi abbonamenti).

- La velocità può scendere nelle ore di punta (dalle 19:00 alle 22:00).